マルチタスク学習とは

マルチタスク学習(Multi-Task Learning)は、機械学習と深層学習の一分野であり、複数のタスクを同時に学習してモデルを訓練する手法です。

従来の機械学習アプローチでは、個々のタスクごとに専用のモデルを訓練することが一般的でした。しかし、マルチタスク学習では、異なるタスク間の共通性や相互関係を活用して、複数のタスクを同時に処理することが可能です。

マルチタスク学習の最大の特徴は、タスク間の情報共有です。複数のタスクを同じモデルで学習することによって、各タスクが互いに役立つ情報を共有することができ、それにより個々のタスクの性能向上が期待されます。

マルチタスク学習の利点

マルチタスク学習にはいくつかの利点があります。

- データとリソースの再利用

- データに付けるラベルの削減

- タスク間の相互作用

シングルタスク学習では、各タスクに対して個別のモデルを訓練する必要があり、大量のデータと計算リソースが必要です。しかし、マルチタスク学習では、複数のタスクを同じモデルで処理するため、データとリソースの再利用が可能となります。

また、マルチタスク学習は、データのラベル付けが困難なタスクにおいて有効です。例えば、医療画像解析では病変の検出と病名の予測など、異なるタスクが関連しており、同じ画像データを共有して学習することが重要です。

最後に、マルチタスク学習は、複数のタスク間での情報共有によって、各タスクの性能向上をもたらすことがあります。例えば、自然言語処理のタスクにおいて、文章の意味理解と文章生成のタスクを同時に学習することで、両方のタスクが相互に恩恵を受けることがあります。

シングルタスク学習との違い

マルチタスク学習とシングルタスク学習との主な違いは、タスクの個数とモデルの設計です。シングルタスク学習では、個々のタスクごとに専用のモデルが訓練され、各モデルはその特定のタスクに焦点を当てて最適化されます。

一方、マルチタスク学習では、複数のタスクを同じモデルで同時に学習し、各タスクがモデル内で情報を共有します。そのため、マルチタスク学習ではリソースの効率よく利用でき、異なるタスク間の相互関係を活用することができます。

マルチタスク学習の応用例

マルチタスク学習はさまざまな分野で応用されますが、最初に自然言語処理(NLP)について見てみましょう。マルチタスク学習は、文章の意味理解、文章生成、質問応答など、NLPタスクの複数のタスクを同時に処理するのに便利です。共通の言語表現を学ぶことで、各タスクの性能向上が期待されます。

共通の表現を学習する事例として、スペイン語から日本語の翻訳タスクを考えてみます。既にスペイン語から英語の翻訳と、英語から日本語の翻訳が学習されたモデルであれば、スペイン語から日本語への翻訳も可能であると報告があり、このようなモデルはゼロショットネットワークと呼ばれます。

次に、コンピュータビジョン分野では画像認識、物体検出、セグメンテーションなどにおいて、マルチタスク学習は広く使用されています。異なるタスクの間で視覚的な共通性を学び、精度向上をもたらします。

マルチタスク学習では共通性を重視しており、汎用的な特徴を学習するのに長けた手法です。

マルチタスク学習の基本

タスク間の相互関係

マルチタスク学習の中心にあるのは、異なるタスク間の相互関係です。これは、複数のタスクを同時に学習し、モデルを訓練する際に非常に重要な要素です。タスク間の相互関係が存在すると、マルチタスク学習はより効果的に機能し、個々のタスクの性能向上に貢献します。

共通の特徴やパターンが複数のタスクで共有されることがあり、例えば自然言語処理の場合、文法の理解や意味の解釈などのタスクでの特徴は多くの言語で共通認識を有する点です。

一部のタスクで不足している情報を他のタスクが提供できる場合は相互関係はより強調されるため、モデルの性能を向上させることができます。転移学習の観点からも、一部のタスクで学習された知識を他のタスクに転移させることが可能です。

タスクの選択と設計

マルチタスク学習で重要な項目について深掘りしてみましょう。

- タスクの難易度

- タスクの学習順序

- データの収集と前処理

まず、タスクの難易度について、一部のタスクが他のタスクよりも難しい場合にモデルは容易なタスクに過度に適応してしまう可能性があります。そのため、タスクの難易度を均衡にするか、公平な学習の設計が必要です。

タスクの順序について、タスクをモデルにどの順序で提供するかも重要で、一部のタスクは他のタスクを事前に学習してから取り組むことが効果的な場合があります。

データの収集と前処理も重要で、各タスクに適切なデータセットを収集してデータの品質や特徴の選択に注意することが必要です。データの品質や特徴抽出の質は、モデルの性能に直接影響します。

マルチタスク学習の実装

マルチタスク学習の主な実装の流れは以下の手順です。

- データの前処理

- モデルの設計

- モデルのトレーニング

import torch

import torch.nn as nn

import torch.nn.functional as F

import torch.optim as optim

import matplotlib.pyplot as plt

from torchvision import datasets, transforms

# MNISTのデータセット準備

transform = transforms.Compose([transforms.ToTensor()])

train_set = datasets.MNIST('./data', train=True, download=True, transform=transform)

test_set = datasets.MNIST('./data', train=False, transform=transform)

batch_size = 64

train_loader = torch.utils.data.DataLoader(train_set, batch_size=batch_size, shuffle=True)

test_loader = torch.utils.data.DataLoader(test_set, batch_size=batch_size, shuffle=False)

# 全結合モデルの定義

class Multitask_Model(nn.Module):

def __init__(self):

super().__init__()

self.fc1 = nn.Linear(784, 128)

self.fc2 = nn.Linear(128, 64)

self.fc3 = nn.Linear(64, 32)

self.digit_fc = nn.Linear(32, 10) # 数字分類用

self.parity_fc = nn.Linear(32, 2) # 奇数偶数分類用

def forward(self, x):

x = x.view(-1, 784)

x = F.relu(self.fc1(x))

x = F.relu(self.fc2(x))

x = F.relu(self.fc3(x))

digit_logit = self.digit_fc(x)

parity_logit = self.parity_fc(x)

return digit_logit, parity_logit

model = Multitask_Model()

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters())

# 学習

num_epochs = 10

loss_history = []

for epoch in range(num_epochs):

running_loss = 0

for batch in train_loader:

img, label = batch

parity_label = label % 2

optimizer.zero_grad()

digit_logit, parity_logit = model(img)

digit_loss = criterion(digit_logit, label)

parity_loss = criterion(parity_logit, parity_label)

loss = digit_loss + parity_loss

running_loss += loss.item()

loss.backward()

optimizer.step()

avg_loss = running_loss / len(train_loader)

loss_history.append(avg_loss)

print(f'epoch: {epoch}, loss: {avg_loss}')

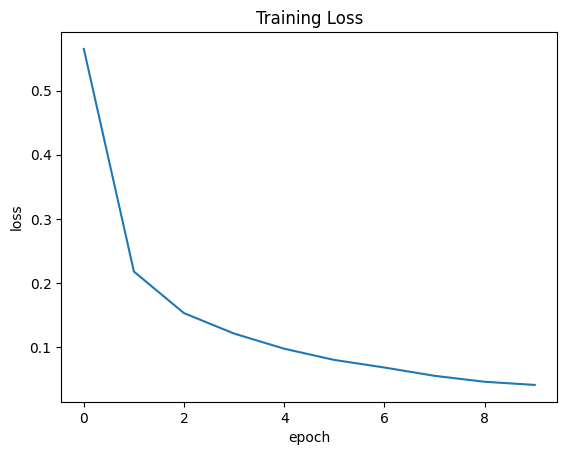

# 損失のグラフ描画

plt.plot(loss_history)

plt.title('Training Loss')

plt.xlabel('epoch')

plt.ylabel('loss')

plt.show()

上記のコードでは有名な手書き数字のデータセットであるMNISTに対して、「何の数字か」と「奇数と偶数のどちらか」を別タスクとして学習しています。シンプルな全結合層モデルですが、エポックが進むにつれて損失関数が小さくなったことがグラフから読み取れますね。

実装には代表的な機械学習ライブラリのPyTorchを利用しました。PyTorchはモデルの構造を細かく指定できるため、研究でも主に利用されています。

マルチタスク学習の活用例

マルチタスク学習は、さまざまな分野で成功事例が報告されていますが、特に自然言語処理とコンピュータビジョンが効果的です。

自然言語処理のマルチタスク学習

自然言語処理のマルチタスク学習の成功事例として、BERT(Bidirectional Encoder Representations from Transformers)モデルが挙げられます。BERTの特徴は、文書分類や質問応答、機械翻訳、意味解析などに対する高い性能です。

BERTは事前学習されたモデルで、大規模なコーパスから文脈を理解し、その知識をさまざまなタスクに転用できるように設計されています。異なる自然言語処理タスクでシングルモデルのみを使用して高い性能を達成し、多くの研究と実用アプリケーションに影響を与えました。

コンピュータビジョンのマルチタスク学習

コンピュータビジョンにおいても、マルチタスク学習は成功事例が多く見られます。例えば、物体検出とセグメンテーションのタスクを同時に学習するモデルがあります。

このアプローチは、自動運転車載システムや画像認識アプリケーションに適用され、効果的に物体の位置を特定し、画像内の領域を認識します。さらに、顔認識、感情認識、および年齢推定などの顔関連タスクを同時に学習するモデルも存在します。

『Tech Teacher』3つの魅力

魅力1. オーダーメイドのカリキュラム

『Tech Teacher』では、決められたカリキュラムがなくオーダーメイドでカリキュラムを組んでいます。「質問だけしたい」「相談相手が欲しい」等のご要望も実現できます。

魅力2. 担当教師によるマンツーマン指導

Tech Teacherでは、完全マンツーマン指導で目標達成までサポートします。

東京大学を始めとする難関大学の理系学生・院生・博士の教師がが1対1で、丁寧に指導しています。

そのため、理解できない箇所は何度も分かるまで説明を受けることができます。

魅力3. 3,960円/30分で必要な分だけ受講

Tech Teacherでは、授業を受けた分だけ後払いの「従量課金制」を採用しているので、必要な分だけ授業を受講することができます。また、初期費用は入会金22,000円のみです。一般的なプログラミングスクールとは異なり、多額な初期費用がかからないため、気軽に学習を始めることができます。

まとめ

・魅力1. 担当教師によるマンツーマン指導

・魅力2. オーダーメイドのカリキュラム

・魅力3. 3,960円/30分で必要な分だけ受講

質問のみのお問い合わせも受け付けております。

まとめ

マルチタスク学習は異なるタスクの共通性を活かして性能を高める手法です。コンピュータビジョンや自然言語処理の分野では成功事例が数多く報告されており、最新の研究について調べてみると発見があるかもしれません。シングルタスク学習の実装に経験がある方は、ぜひマルチタスク学習も実装してみましょう。